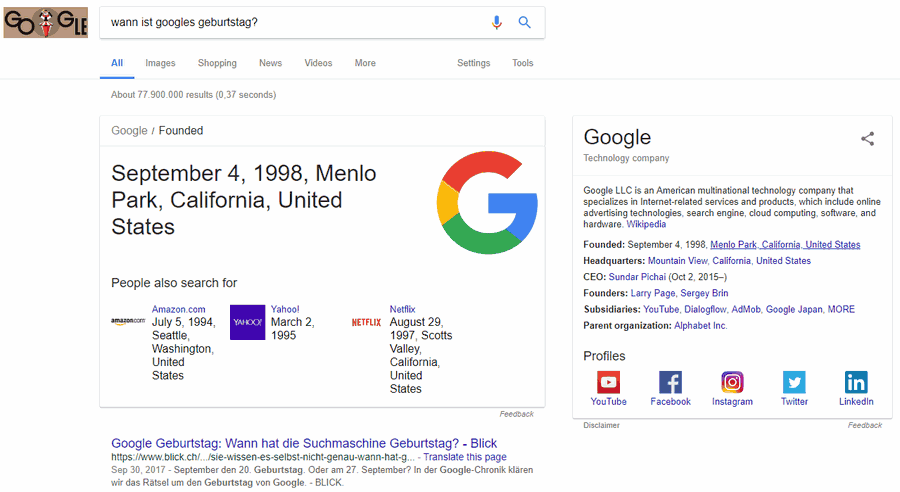

Heute ist Googles zwanzigster Geburtstag. Zumindest wenn man Googles Suchmaschine vertrauen mag. Und die sollte das doch eigentlich wissen. Wenn ich in Googles Suchformular die Frage „Wann ist Googles Geburtstag?“ eintippe, so verrät mir die Suchmaschine mit Hilfe zweier Infoboxen, dass das Unternehmen am 4. September 1998 gegründet wurde.

Google, SEO, SSL – Lieber langsam, oder schnell?

Vor 25 Tagen, am 6.08.2014, verkündete Google, dass SSL ein Ranking-Signal sein wird. Zwar nur ein kleines, aber immerhin. Damit kam natürlich Schwung in die Diskussionen über den Sinn und Unsinn von SSL als SEO Faktor. Ich habe zwar keine Zahlen vorliegen, der Abverkauf von SSL Zertifikaten dürfte aber krass in die Höhe geschnellt sein … Weiterlesen …

Pinguin Update Wettbewerb April 2014

Vor über 11 Jahren habe ich im legendären Suchmaschinentricks Forum zum Google Dance Wettbewerb aufgerufen. Damals musste man als SEO viel Geduld aufbringen, oftmals dauerte es Wochen bis sich die Google Rankings veränderten. Ich habe vorhin mal einen alten Beitrag aus dem Internet Archiv gezogen. Das Forum selber existiert ja leider nicht mehr. Waren das … Weiterlesen …

Strukturierte Daten – einfach erklärt

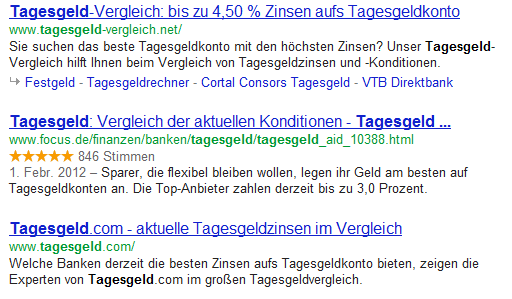

Heutzutage integriert Google verschiedenste Inhalte in die Ergebnislisten. Ohne prägnante Ergänzungen wie Videos, der Autorenverknüpfung und Bewertungssternen wird es immer schwieriger vom Suchenden in den Suchergebnislisten wahrgenommen und angeklickt zu werden. In einem Artikel von Search Engine Land wurde dieses Thema kürzlich aufgegriffen. In diesem Artikel zeigen wir die Vorteile strukturierter Daten, sowie die Verwendung … Weiterlesen …

Google und die Blogs – eine Hass-Liebe

Seit es Blogs gibt, wird auch immer wieder die Rede darauf gebracht, dass Google Blogs liebt. Und dem war auch so. Jahrelang kletterten die Blogs die Serps hinauf und sonnten sich an den obersten Positionen. Das sollte auch niemanden verblüffen, Blogsysteme wie WordPress machten fast alles richtig, was die Aufbereitung und Präsentation der Inhalte anging. … Weiterlesen …

Google disavow links

Seit gestern gibt es das Google Disavow Links Tool. Disavow bedeutet so viel wie ablehnen, (ab)leugnen, nicht anerkennen. Das Tool ist Bestandteil der Google Webmaster Tools (Login erforderlich) und kann dazu genutzt werden, böse bzw mißliebige Links aus dem Backlinkprofil der eigenen Website zu entfernen. Wobei das Disavowen / Ablehnen eines Links nicht zwingend zur … Weiterlesen …

Benachrichtigung von Google Webmaster-Tools über unnatürliche Links, die auf xxx gefunden wurden

Am 19.07.2012 gab es für die Website eines Kunden eine Benachrichtigung von den Google Webmaster-Tools über unnatürliche Links mit folgendem Wortlaut: Sehr geehrter Inhaber oder Webmaster von xxx, [Anmerkung der Redaktion, aus nicht schwer nachvollziehbaren Gründen wurde der Link entfernt.] Wir haben festgestellt, dass auf einigen Seiten Ihrer Website eventuell Techniken verwendet werden, die gegen … Weiterlesen …

Sternchenbewertungen in den SERP mit Wordpress in 5 Minuten

In den letzten Wochen und Monaten wurde der Klickraten-Vorteil durch Sternchenbewertungen von vielen SEOs heiß diskutiert. Seit der öffentlichen Anprangerung durch Arthur ist das Thema auch in öffentlichen Blogs und Foren. Ich zeige euch in diesem Artikel, wie ihr solche Bewertungen ganz einfach in eure Wordpress-Artikel einbinden könnt.

Nachtrag: Bitte auch die Kommentare unter diesem Artikel bezüglich Manipulation durch Mitbewerber und Integration direkt ins Template (ohne Shortcode in jedem Beitrag) beachten.

Panda Update in Deutschland angekommen

So, da haben wir den Salat. Das lange angekündigte Panda Update ist jetzt auch in Deutschland angekommen. So zu lesen seit heute Mittag auf den Seiten der Google Webmasterzentrale. Nachdem im April 2011 das internationale Panda Update nur gegen englischsprachige Webseiten gerichtet war, erfolgte jetzt also ein weltweiter Panda Rollout. Damit ist Panda endlich auch … Weiterlesen …

Google Plus oder das Strohfeuer der Gewöhnung

Autsch, wie ich diese Meldungen hasse. Google Plus ist noch nicht richtig draußen, da kommen schon die ersten statistikunterlegten Unkenrufe. Ist Google Plus nur ein Strohfeuer? Der Traffic von Google Plus scheint zu sinken. Auslöser der negativen Berichterstattung ist eine Untersuchung von Hitwise die belegen soll, dass Googles Zugriffszahlen für den neuen Service mittlerweile minus … Weiterlesen …